Matemáticas

y Geometrías COMPLEJAS

Las matemáticas y la geometría son uno de

los pilares sobre los que se ha construido la modernidad. Desde la antigüedad

las matemáticas han sido culto de veneración, eran consideradas el lenguaje en

el que Dios había escrito el universo, un saber absoluto y principio ordenador

anterior a la creación. Por eso mismo, algunos dirán que las matemáticas no son

una ciencia, sin embargo, como se verá más adelante, las matemáticas son

modelos que surgen de la experiencia y como tales están sujetas a todas las vicisitudes de cualquier campo científico. Las últimas décadas han estado

marcadas por descubrimientos sorprendentes que han revolucionado el modo de

construir modelos lógicos y nos han permitido movernos por las fronteras del

conocimiento para descubrir nuevos alcances de los mismos.

Matemáticas Modernas en Perspectiva

Todo principio matemático tiene la experiencia

como primer fundamento, solo más tarde, con la constante formalización de la

disciplina, las matemáticas adquieren un alto grado de abstracción. Desde

tiempos muy antiguos las primeras culturas demostraron tener conocimientos de

aritmética y geometría, ellos observaron el cosmos y los ciclos de la

naturaleza y “descubrieron” patrones que se formalizaron en estructuras

lógico-geométricas. Buenos ejemplos de ello lo encontramos en estructuras

arquitectónicas antiguas como las Pirámides o Stonehenge (Feyerabend, 2013).

Pero ¿Son aquellos patrones matemáticos

características del mundo real o propiedades de nuestro espíritu que se

proyectan en nuestra experiencia? Desde pequeños comenzamos a identificar

propiedades en los objetos: lejos o cerca, arriba o abajo, poco o mucho, rápido

o lento, luminoso u oscuro, dentro o fuera, etc. Se cree que las primeras formas de cálculo se derivan del uso de los

dedos pues la mayoría de los sistemas numéricos son a la base de 5 o 10. Tales

sistemas no tardarían en graficarse con sistemas de notación como el ábaco, los quipu u otras formas de escritura.

Todo esto nos indica que las primeras

nociones matemáticas son relaciones entre fenómenos u operaciones

sensorio-motrices.

Al desarrollarse formas gráficas de notación, las

matemáticas fueron adquiriendo una lógica cada vez más formal o abstracta. La

lógica aristotélica definió tres grandes principios que se convirtieron luego

en fundamentos del determinismo: (1) un elemento es siempre idéntico a sí

mismo, (2) una proposición no puede ser y no ser al mismo tiempo, y (3) cada

fenómeno tiene una causa que explica su movimiento. Estos principios suponen,

que cada elemento es independiente, que tiene propiedades determinadas, y que las

relaciones lógicas entre los elementos pueden ser determinadas en forma precisa

(Aristóteles, 1997; 1982).

Laplace (1814) es considerado el máximo

representante del determinismo, en su

versión más estricta aseguró que

si se conocieran “todas las fuerzas que animan la naturaleza y las posiciones

de los seres que la componen…” se podría diseñar una fórmula matemática simple

que permitiría determinar el comportamiento de cada evento dentro del universo.

No obstante, el mismo Laplace debió asumir que en ciertos casos los resultados

de un suceso solo se podían predecir en términos probabilísticos, llamó a tales

fenómenos eventos aleatorios. Pero, cabe preguntarse ¿qué hay detrás de lo

indeterminado?; ¿acaso los elementos no tienen una identidad definida?; ¿acaso

tales elementos no tienen propiedades características?; ¿acaso los eventos no

tienen una causa que pueda definirse en una formula?

La relatividad ya la encontramos en las

formulaciones geométricas más sencillas. Por ejemplo la geometría dimensional,

muestra como las manifestaciones de un mismo fenómeno en distintas dimensiones

pueden diferir entre sí, y cuando fenómenos diferentes se proyectan en una

única dimensión pueden manifestar una estructura ambigua o inconsistente

(Frankl, 2012). Entonces ¿no serían los resultados matemáticos relativos dependiendo

de la perspectiva con la que se mire?

De mano de Leibniz y Newton las

matemáticas modernas abordaron desafíos esquivos hasta entones como el estudio

de lo infinito y del movimiento, son campos de conocimientos que hoy conocemos

como cálculo diferencial e integral. Sin embargo, las matemáticas modernas esquivaron otro tipo de

problemáticas: “En la naturaleza no se encuentran nunca cambios perfectamente

uniformes, tal como que exige la idea que las Matemáticas nos dan del

movimiento, ni tampoco en rigor figuras actuales, de la naturaleza de las que

la Geometría nos enseña… Pero la comprobación de todas estas reglas en su

aplicación al mundo real o a las discusiones metafísicas, no interesan a los

matemáticos, porque el cálculo infinitesimal les ha enseñado que basta con una

regla de aproximación indefinida a una cantidad tan pequeña o tan grande como

se quiera, sin que haya que seguir ese camino paso por paso”según comentaba Leibniz

(De Mora, 2012).

Complejidad

Las matemáticas modernas solo nos permiten

identificar ciertas tendencias que nos ayudan a bosquejar la dinámica de

algunos procesos, y aunque son un acercamiento al tema de la complejidad, aun

está lejos de abordar los problemas en su real dimensión. Las matemáticas

modernas sabían que todos sus cálculos modelaban con cierto margen de error los

fenómenos reales, solo que reducían ese margen de error hasta lo infinitamente

pequeño. Pero ¿Cómo abordar fenómenos de gran complejidad como el

funcionamiento del cerebro, los ecosistemas o los intercambios culturales,

donde la gran cantidad de rangos de error procedentes de infinidad de variables

se potencian entre sí? Cabe destacar que cuando se multiplican hechos

independientes la probabilidad total disminuye, sin embargo, cuando se

potencian fenómenos relacionados las probabilidades aumentan.

Como explica Ashby (1976), es fundamental

que el sistema descrito tenga suficiente variabilidad interna, es decir un

elevado grado de complejidad para describir con precisión sus contingencias.

Esta complejidad básicamente está dada por: la cantidad mínima de elementos con

las que puede describir un sistema numérico sin perder información (por ejemplo

el sistema binario tiene un menor nivel de complejidad que el sistema decimal) y

la cantidad bits de información. De este modo, la descripción precisa de

fenómenos complejos nos remite a la teoría de conjuntos, específicamente a la

forma de agrupar las propiedades de un sistema. En caso que el modelo

matemático considere una menor cantidad de conjuntos su capacidad descriptiva

puede disminuir significativamente. El problema de esto, es que la cantidad de

elementos que describen un hecho son relativos o arbitrarios, pues la cantidad

de variables que se introducen en una formula tienden hacia el infinito en

medida que se profundiza en el nivel de análisis. Vemos, entonces dos

principios derivados de este campo de estudio: primero, que la complejidad de

un fenómeno relacionado con la dificultad de descripción de un elemento;

segundo, que los conjuntos tendrán distintas características dependiendo del

nivel de análisis o las unidades de medida con que se estudien. Por eso, los

sistemas complejos constituyen en nuestros días un gran desafío para el mundo

matemático, de hecho es probable que se nos haga imposible abordarlas sin la

ayuda de las herramientas computacionales y en complemento con metodologías

cualitativas (Cardozo, 2011).

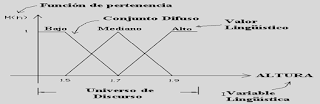

Conjuntos Difusos

Uno de los problemas de las matemáticas

modernas se encuentra en la forma en que trabajan variables ambiguas o con una

definición difusa, pues desde los principios lógicos del aristotelismo la

ambigüedad podría oponerse el principio de no contradicción. No obstante, desde

las matemáticas complejas se viene trabajando en una teoría que puede abrir

nuevos horizontes a esta disyuntiva, al diseñar una nueva metodología para

formalizar sistemas lógicos según criterios de pertenencia difusos (no son

nítidos).

Desde la teoría de conjuntos difusos

(Zadeh, 1965) un elemento puede pertenecer y no pertenecer a la vez a un mismo

conjunto, por ejemplo, si decimos que un clima es caluroso ¿Cómo definimos un

criterio para determinarlo?, un matemático moderno crearía categorías con

intervalos de corte arbitrarios para definirlo, hasta tantos grados hace frío,

entre tantos grados está tibio y con más de tanta temperatura hace calor, en

fin, lo que propone la teoría de conjuntos difusos es que esos rangos de

temperatura pueden sobreponerse unos a otros, de modo que puede estar frío y

tibio al mismo tiempo o incluso frío y caluroso al mismo tiempo. Es interesante

notar que la teoría de conjuntos es especialmente útil en la descripción de

fenómenos de mayor complejidad, que suelen caracterizarse por la superposición

de múltiples conjuntos.

Los conjuntos difusos no establecen

distinciones en base a simple distribuciones probabilísticas como se hace con la

curva de gauss, más bien se trata de un nuevo modo de aproximarse a la realidad

y construirla conceptualmente de modo que dos hipótesis sobre un mismo fenómeno pueden

subsistir. La implicancias de esta teoría pueden ser considerables a nivel

epistemológico y por consecuencia sobre el modo en que exploramos hipótesis

científicas, construimos cuerpos teóricos y permitimos la subsistencia de

sistemas culturales (Munne, 1994).

Fractales

El modelo con que se describe un fenómeno

se deriva del nivel de profundidad con el que se analiza. Fiel reflejo de ello

es el maravilloso mundo de los fractales, donde podemos estudiar integradamente

fenómenos complejos en sus diversos niveles organización, desde lo micro a lo

macro. Tal como los describe Mandelbrot (1967; 2007), los fractales son modelos

geométricos que siguen patrones autosimilares, tal como los encontrados en la

naturaleza, en el mundo vegetal, en los cristales de hielo, en la geografía, en

la meteorología, etc. Estas figuras son formaciones geométricas irregulares o

fragmentas que repiten un patrón de desarrollo a distintas escalas, de modo que

cuando usamos unidades de medida más pequeñas podemos contar un diámetro

mayor, pues su dimensión es un número no entero o fracción. Por ejemplo, si

queremos medir el largo de Chile podemos usar una unidad de medida de cientos

de kilómetros y tener un resultado aproximado, pero si disminuimos nuestra

escala y medimos en centímetros, tendremos que fijarnos en las pequeñas

entradas de agua en cada una de las rocas lo que nos llevará a calcular un

perímetro mucho mayor, también podríamos medirlo en milímetros, micras o

unidades de medida infinitamente pequeñas lo que nos llevaría a una cifra aún

mayor ¿Cuál de las medidas es válida? obviamente es relativo, algunos

matemáticos dirían que simplemente no tiene una extensión determinada, otros

más bien se inclinan a decir que tiene todas esas medidas al mismo tiempo.

Los fractales han fascinado a

científicos, místicos y artistas, quizá sea por su recursividad autosemejante o

por otras de sus sorprendentes cualidades. La mayoría de las representaciones

fractales provienen de un algoritmo que se transforma en una impresión digital

que se puede explorar a medida que nos acercamos o alejamos de sus vórtices,

así podemos considerar un detalle del fractal, pero cuando nos introducimos en

el para explorarlo nos damos cuenta que se trata de un intrincadísimo mundo

geométrico lleno de detalles, y cada uno de esos detalles es un mundo por sí

mismo lleno de pequeños mundos, y así hasta el infinito, mundos dentro de

mundos y dentro de mundos. Los fractales se resisten a ser representados, son

siempre figuras parciales o incompletas por su infinita riqueza interior (o

exterior dependiendo de la perspectiva), solo podemos explorar su contorno,

viajando por ella en sus distintas escalas de medida, aún así, por más profundo

que exploremos nunca llegaremos a conocer su real dimensión. Por eso, los fractales

abren nuestras puertas hacia nuevas formas de pensamiento, el pensamiento

fractal no da un lugar privilegiado ningún reduccionismo o absolutismo. Lo más

pequeño puede ser grandioso y lo más grandioso solo adquiere identidad por

aquellas insignificancias que las componen (Ortiz, 2006).

No- Linealidad y

Atractores Caóticos

Ya hemos hablado de que las matemáticas

complejas introducen la lógica de conjuntos difusos y la geometría fractal,

pero el rasgo más característico de las nuevas matemáticas, la encontramos en

la no-linealidad de los sistemas dinámicos. Se les llama matemáticas no-lineales

porque sus procesos no pueden ser determinados mediante una regresión lineal en

función de una serie de variables independientes como se hace en álgebra clásica.

Las matemáticas modernas abordaban la

dinámica de los sistemas desde el cálculo diferencial e integrado, y así

lograban detectar predecir o explicar la mayoría de los fenómenos, no obstante,

también existía una parte de los datos que no lograba explicarse. Según Poincaré

(Delshams, 2004) la clave para entender estos sistemas dinámicos no-lineales

estaba en pequeños detalles de sus condiciones iniciales que muchas veces eran

difíciles de precisar, pero que en el curso de la evolución del sistema los

efectos de esas pequeñas condiciones iniciales se acumulaban hasta generar

efectos contraintuitivos de magnitud, que terminaban por cambiar completamente

el funcionamiento del modelo matemático que lo describía. Así por ejemplo, un

modelo matemático que en general funcionaba según una ecuación lineal clásica

(determinista), repentinamente se comportaba según principios aleatorios,

pasando del orden al caos de modo abrupto.

Muchos fenómenos cotidianos parecen

contradecir nuestra lógica, podemos decir por ejemplo “el día estaba brillante

y despejado, nada predecía que ese día hubiera tormenta”, los matemáticos

siempre han quedado intrigados ante estos procesos y han diseñado intrincados

modelos geométricos para describirlos. Probablemente la forma más fácil de

modelar un sistema dinámico no-lineal es con atractores. Los atractores son

modelos que describen la trayectoria de ciertos indicadores en un sistema

dinámico. Digamos que un conjunto de estados de un sistema son descritos unos

tras otros en una cinta de medir, cada uno se sus números describe la

trayectoria que presenta la variable, si la cinta está estirada diremos que se

trata de un atractor muy simple o de comportamiento clásico, también diremos

que se trata de un atractor clásico si juntamos los extremos de una corta cinta porque

podremos predecir relativamente bien cuales números vendrán en seguida de otros,

en este último caso se repetirán periódicamente: 1,2,3,4,5,1,2,3,4,5…Sin

embargo, no podremos decir lo mismo de una extensa cinta plegadas en cientos de

partes, donde unas partes se contectan con otras como una madeja de lana, entonces

diremos que debido a su complejidad la continuidad de la cinta se vuelve casi

impredecible pues la periodicidad de los números se vuelve más infrecuente:

1,3,4,5,9,6,1,3,5,8,2,6,3,9…2,8,5,1……..1,3,4,5,9…etc. llamamos entonces a estos

modelos atractores extraños o caóticos (Capra, 2004).

Uno de los atractores caóticos más

conocidos es el atractor de Lorenz, el cual describe fenómenos de convección meteorológica

de alta complejidad mediante ecuaciones no-lineales. En este atractor se

aprecia como una causa inicialmente irrelevante puede magnificarse hasta

generar un efecto que podría parecer inicialmente desproporcionada, sabemos que

se pueden hacer prediciones con este modelo si conocemos con mucho detalle las

condiciones inciales del modelo, sin embargo, en la práctica la complejidad del

atractor hace casi imposible realizar prediciones que no sean próximas en el

tiempo, por ejemplo, desde prácticamente el mismo punto de origen dos

trayectorias pueden tomar cursos de desarrollo completamente distintos (Lorenz,

1963).

El estudio de este tipo de atractores extraños

y de las ecuaciones no-lineales se ha

transformado en todo un campo de investigación donde se cruzan la teoría de las

catástrofes o la teoría del caos o de estructuras discipativas.

La teoría de catástrofes, desarrollada

por René Thom (1977), es una rama de investigación que estudia básicamente las

bifurcaciones de trayectoria de los sistemas dinámicos, es decir, los cambios

repentinos del comportamiento de un sistema dinámico. Es un área de las

matemáticas que combina la creación de modelos matemático-geométricos sobre el

comportamiento de sistemas para luego estudiar cualitativamente la topología

diferencial de dichos modelos, es entonces un ámbito que estudia como

evolucionan las formas o morfologías, por eso se dice que se puede entender como

una teoría morfogenética.

Por otra parte, el estudio de las estructuras

discipativas es un campo de investigación, iniciado por Ilya Prigogine (2008),

que trata sobre la forma en que se comportan los sistemas alejados del

equilibrio. Muchos de los principios que se han mencionado dentro de las

matemáticas complejas son aplicables a este campo de estudio; lo que se ha

observado es que los sistemas caóticos, que están discipando energía, es que experimentan cambios de transiciones de fase

en modo estacionario, de modo que en cada salto se configuran nuevas

estructuras autoorganizadas, son entonces una forma morfogenética que se

expresa ante ciertas condiciones en particular. Todas estas transiciones de

fase han dado sustento a la teoría morfogénética de Turing, lo que ha permitido

explicar la emergencia los patrones en el mundo natural (Martín-Sánchez,

Martín-Sánchez y Pinto, 2012).

Incompletud

No obstante, suponiendo que logremos

describir un sistema lógico-matemático-geométrico con suficiente complejidad

nos encontramos con otro tipo de problemas. A finales del siglo XIX, Hilbert propuso

una serie de desafíos que impulsaron la investigación más allá de las fórmulas

y ecuaciones. Una de las problemáticas más intrigantes fue abordada por Godel.

En términos sencillos, Godel (Ballester, Cordero, Campos, Sánchez y Rodríguez, 2012) se preguntaba: “¿Puede contestarse toda

pregunta matemáticamente bien enunciada?”, en otras palabras “¿Todo enunciado

matemático-lógico es demostrable, ya sea algo falso o verdadero?”. La respuesta

la encontramos en el teorema de incompletud, esta teoría establece que

cualquier sistema lógico es por necesidad incompleto y requiere una referencia

externa para comprobarse a sí mismo, y por lo tanto, toda arquitectura

argumental cerrada se sustenta en axiomas que no pueden probarse ni refutarse

por sí mismos. Más adelante, Turing (De la Fuente, 2010) trató de formular este

problema mediante un algoritmo computacional, demostrando que una máquina solo

es capaz de reconocer conjuntos recursivos de signos y que no existe un

algoritmo capaz de decidir sobre una proposición externa a este sistema

recursivo. Es que la complejidad reside precisamente en la interdependencia

entre los fenómenos, incluido el observador.

Hay problemas que definitivamente no

pueden ser resueltos en los sistemas lógico-matemáticos-geométricos descubiertos hasta el momento. Como explica Wiener (1964), en lo que respecta a nociones

espirituales superlativas como la omnipotencia y omnisciencia, donde la lógica

tiende hacia el infinito, se entra en el terreno de las llamadas formas

indeterminadas, de modo que la lógica matemática no se ajusta a los cálculos

con números ordinarios (infinito dividido infinito, infinitas veces cero, o

infinito menos infinito, cero dividido cero, etc.).

BIBLIOGRAFÍA

http://vidaculturaycosmos.blogspot.cl/2017/02/bibliografia.html

BIBLIOGRAFÍA

http://vidaculturaycosmos.blogspot.cl/2017/02/bibliografia.html

No hay comentarios:

Publicar un comentario